数据安全风险评估思路

导读:最早是“信息安全风险评估”,随着信息安全领域的细化,衍生出“数据安全风险评估”。.共同目标是保护数据的CIA安全三要素,国标《信息安全技术 信息安全风险评估实施指南》中风险评估的流程同样适用于数据安全的风险评估。.保密性(Confidentiality):确保信息只能被授权的人或

最早是“信息安全风险评估”,随着信息安全领域的细化,衍生出“数据安全风险评估”。

共同目标是保护数据的CIA安全三要素,国标《信息安全技术 信息安全风险评估实施指南》中风险评估的流程同样适用于数据安全的风险评估。

保密性(Confidentiality):确保信息只能被授权的人或实体访问和查看,防止未经授权的人或实体获取敏感信息。

完整性(Integrity):确保信息在传输或存储过程中不被篡改或损坏,保证信息的准确性和完整性。

可用性(Availability):确保信息在需要时能够访问和使用,防止服务中断、拒绝服务等情况发生,保证信息的连续性和可用性。

以下是对于数据安全风险思路框架的梳理,以保证如何能做到不重不漏、更加全面的评估安全风险。

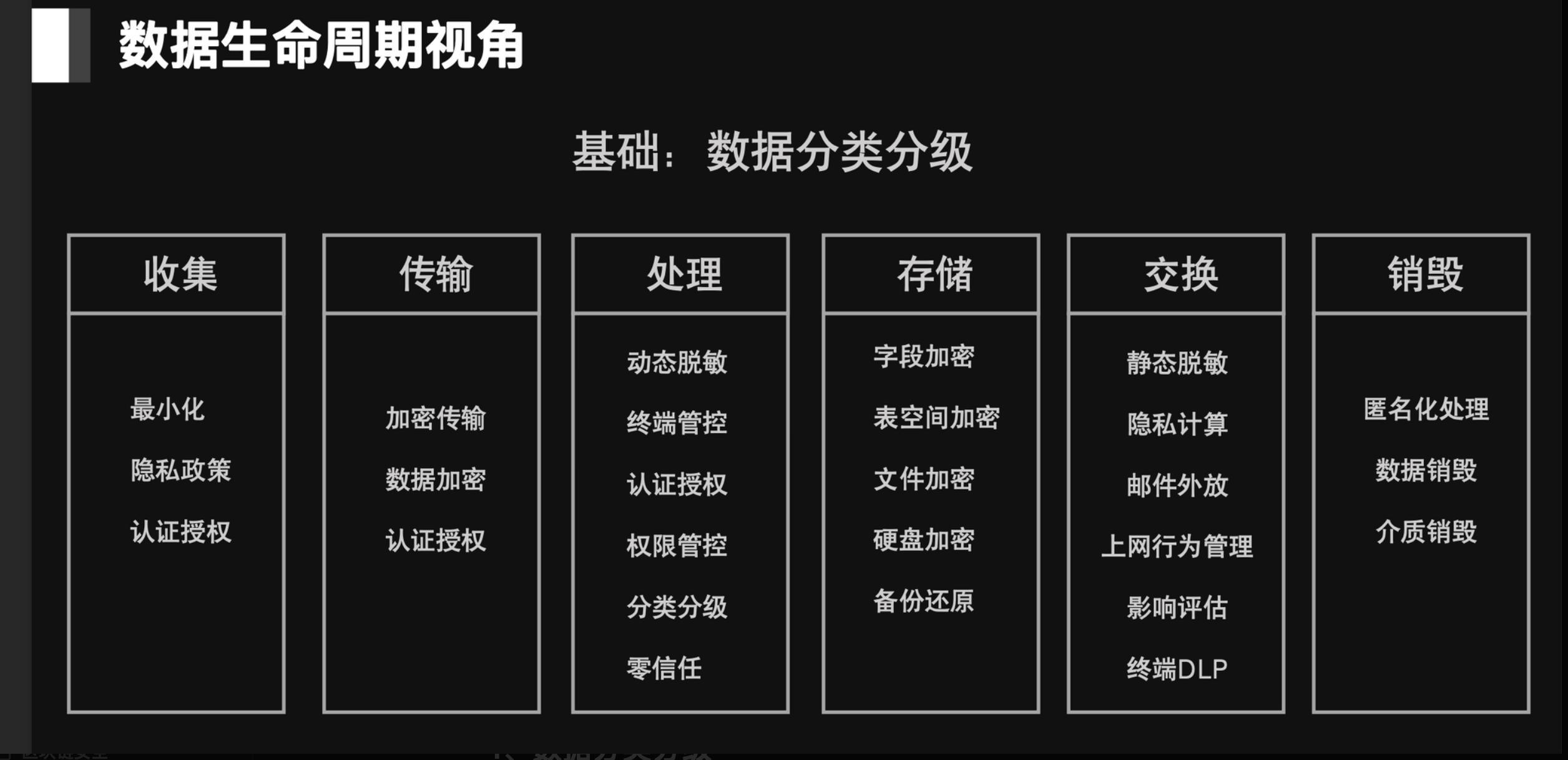

一、生命周期

生命的周期的角度包含了被评估对象的全生命周期流程,安全领域最早听说这个词(“全生命周期”)应该是从SDLC(Software Development Life Cycle,软件开发生命周期)。近年来随着数据安全的火爆,DSMM(数据安全能力成熟度模型)成为度量企业数据安全水位的参考,该标准从三个不同的方向维度(数据安全过程维度、数据安全能力维度、能力成熟度等级维度)定义了不同成熟度等级(一级、二级、三级、四级、五级)应该分别满足怎样的安全要求。基于DSMM理念,生命周期成为数据安全治理中较为能想到的一个思路。

1、数据采集

1.1 采集的合法性和正当性

采集前是否有授权: 如,C端隐私政策是否同意、是否有签署数据处理协议 (从第三方采集)

明确采集范围: 数据的频率和量级应遵循最小必要原则

1.2 采集过程安全风险

采集环境安全: Web端环境是否存在安全薄弱点、App端采集完成后是否需删除用户信息、人员访问权限是否合理等;

采集的传输存储过程风险 :认证授权、链路加密、接口鉴权、数据加密

Referer:爬虫安全风险

2、数据传输

传输数据的保密性和完整性、数据加密和通道加密:

- 传输通道加密:使用TLS/SSL 1.3

- 传输数据加密:国际密钥算法(对称和非对称)、国密算法

- 身份认证:对接口进行身份认证,防止未授权访问和越权;如:totken、证书等

- 完整性校验:确保信息传输过程中没有被篡改,如:验签(单向散列函数、HMAC)、数字签名

- 防重放攻击:时间戳、一次性令牌等

- 密钥管理(KMS):生成、存储、分发、导入、导出、使用、恢复、归档与销毁

- 安全审计:对传输过程、异常行为、攻击行为等进行日志记录;

3、数据存储

- 数据存储系统的安全:数据库安全基线、访问配置、数据存储加密(分级加密)、特权账号管理、行为日志审计

- 数据机密性:使用安全的加密算法对敏感信息(至少)进行加密存储

- 访问控制:数据库访问控制权限、特权账户、高敏操作

- 容灾备份:多云/异地、数据备份(分级(重要数据)备份、全量备份、备份频率

- 日志审计:登录、操作行为等日志记录

- 存储期限:到期处理措施(删除、匿名化、、)

4、数据处理

计算、展示

- 脱敏:敏感数据脱敏展示

- 日志:数据处理过程(查询、导出、计算、留存等环节)日志记录

- 权限和访问控制:用户权限/程序访问权限、越权漏洞

- 合规性评估:最小必要、知情同意、合法性评估、PIA影响评估

- 数据分析处理过程安全:导入、导出、使用算法安全性评估、权限、审计、数据处理环境的安全

5、数据交换

共享、委派、出境

1)前置的合规性问题

- 提供给外部第三方:资质审查、数据协议、传输交换过程安全评估

- 数据跨境申报和评估

2)传输交换安全

- 身份认证和鉴权:对传输方进行身份认证、对可请求访问进行认证

- 接口安全:传输加密、敏感信息脱敏、签名验签、通道加密

- 日志审计

3)导入导出安全

6、数据销毁

- 逻辑删除

- 物理删除

- 销毁

- 日志记录

7、通用安全要求

数据安全策略、组织和人员、合规管理、元数据、数据资产管理、供应链管理、安全应急

二、以5A方法论为核心的评估思路

1、网络协议层 &5A

5A:

身份认证(Authentication):用户主体是谁?

授权(Authorization):授予某些用户主体允许或拒绝访问客体的权限。

访问控制(Access Control):控制措施以及是否放行的执行者。

可审计(Auditable):形成可供追溯的操作日志。

资产保护(Asset Protection):资产的保密性、完整性、可用性保障。

网络通信协议逐层 和 5A理论的评估矩阵:

2、业务流程 & 5A

有时在评估具体的业务场景,大而全的框架不好用时,从业务流程节点 和 5A 的角度来思考。例如,业务场景中接口间传输和处理数据,将整个流程中数据从A到B到C…如何请求和返回 画出完整的数据流转图、区分出不同的处理阶段,从业务阶段 和 5A 两个维度分别对应评估点。

3、大数据环境中的5A理论应用

在Hadoop生态集群中,组件众多,除组件自身的安全漏洞、开源组件风险,5A方法论也同样适用:

安全认证

Hadoop集群内最初是默认信任、不需要身份验证和授权的,任何用户都可以伪装成为其他合法用户,访问其在HDFS上的数据,获取MapReduce产生的结果,从而存在恶意攻击者假冒身份,篡改HDFS上他人的数据,提交恶意作业破坏系统、修改节点服务器的状态等隐患。权限控制

用户只要得知数据块的 Block ID 后,可以不经过 NameNode 的身份认证和服务授权,直接访问相应 DataNode,读取 DataNode 节点上的数据或者将文件写入 DataNode 节点。关键行为审计

默认hadoop缺乏审计机制。资产保护——静态加密、动态加密

默认情况下Hadoop 在对集群HDFS 系统上的文件没有存储保护,所有数据均是明文存储在HDFS中,超级管理员可以不经过用户允许直接查看和修改用户在云端保存的文件,这就很容易造成数据泄露。

默认情况下Hadoop集群各节点之间,客户端与服务器之间数据明文传输,使得用户隐私数据、系统敏感信息极易在传输的过程被窃取。

三、风险类型维度

1、合规风险

满足相关法律法规的要求,输出合规清单,依据不同法律效力层级的制度要求,和内部的制度要求进行映射,梳理出内部需要遵从的合规项。

3.2 技术风险

- 安全漏洞风险:OWASP TOP 10、大数据组件漏洞、云上安全风险

3.3 管理风险

- 业务流程

- 产品/平台功能

- 组织与人员风险

- 资产管理风险

四、混合维度

Referer :https://dsre.jd.army/#/

从生命周期、安全三要素、5A、风险类似 几个维度共同定义

上一篇:jenkins+linux+gi

下一篇:在idea/webstorm等t